- 时尚芭莎女士版 2022年1月号 京东自营 苏芒

- 哲学与幼童 [美] 加雷斯·B·马修斯

- 哲学是怎样炼成的 [英] 蒂莫西·威廉森

- 墨点字帖 毛笔字帖楷书九成宫+多宝塔碑+玄秘塔碑+三门记(4本套装) 墨点字帖

- 打胜仗的策略 [Red Teaming] [加] 布赖斯·霍夫曼(Bryce

- Python微控制器编程从零开始 唐纳德·诺里斯

- 十四五与双循环:17位一线经济学家深读解读 新发展格局 经济学家圈

- 如果历史是一群喵7·隋唐风云篇??(京东专享限量历史喵门挂牌) 肥志

- Apache Kafka源码剖析 徐郡明

- 她婊气冲天【民国】 江问渔

- 量子思维:认知和决策的量子模型 杰尔姆·R.布斯迈耶

- 人间有所寄 王蒙

- 培生经典音乐教程 视唱练耳基础 第十版 南希·罗杰斯

- 因为是地狱模式,所以组队吧 翊日亦乐

- 硬笔书法临古描摹练习系列《曹全碑》 李波

- 文徵明·清静经/精缮碑帖 木娄

- 求同存艺 罗易成

- 价值创造 谢家荣

- 柠檬桌子 [英] 朱利安·巴恩斯

- 2024年日历 早餐星球 今天早餐吃什么(绘客出品)、 ChargeWu

- 治愈系生活摄影:拍出幸福的日常 小正

- 国家癌症控制纲要政策与管理指导针 米芾

- 制胜谈判:72战术应对博弈困境 游梓翔

- 生活破破烂烂,狗狗缝缝补补 勒妮·阿尔萨拉夫

- 岸边露伴在卢浮 荒木飞吕彦

- 我的名字叫乔 马丁·德格尔曼

- Android应用安全防护和逆向分析 姜维

- 个人所得税综合所得汇算清缴实务100点 陈志坚

- 第二版 2023世界知识地图(防水 耐折 撕不烂地图)0.96米*0.65米 中国地图出版社

- 天作之合 桑玠

- [鬼灭之刃]弟弟黑化了怎么办? 斟卿

- 抗肿瘤药物靶点与毒性研究 金毅

- 中国艺术哲学(第三版) 朱志荣

- Windows内核编程 谭文

- C语言修仙 一十四洲

- 知识点有画面漫画初中必背诗词 陈磊.混知教育团队

- 战法合集之万法归宗 袁博

- 拈花染墨 古风漫画人物基础入门 哒哒猫

- 暗恋·橘生淮南 八月长安

- 从连接到激活 秦朔

- 中国雕塑史 [日] 大村西崖

- 国民女神爱厨神[娱乐圈] 明月长生

- 麻省理工创新思考力 宫书尧

- 2023年版中华人民共和国工程建设法律法规全书(含全部规章) 法律出版社法规中心

- 英国皇家园艺学会植物繁育手册 艾伦·图古德

- 从Python开始学编程 Vamei

- DK神秘大自然奇观 本·霍尔

- 慢慢来,比较快:插画师的30周学习手册 娈峰哀

- 巨大的拥抱 鐗╀箙淇

- 淘气包马小跳29:七天七夜(签名版) [6岁] 果麦文化

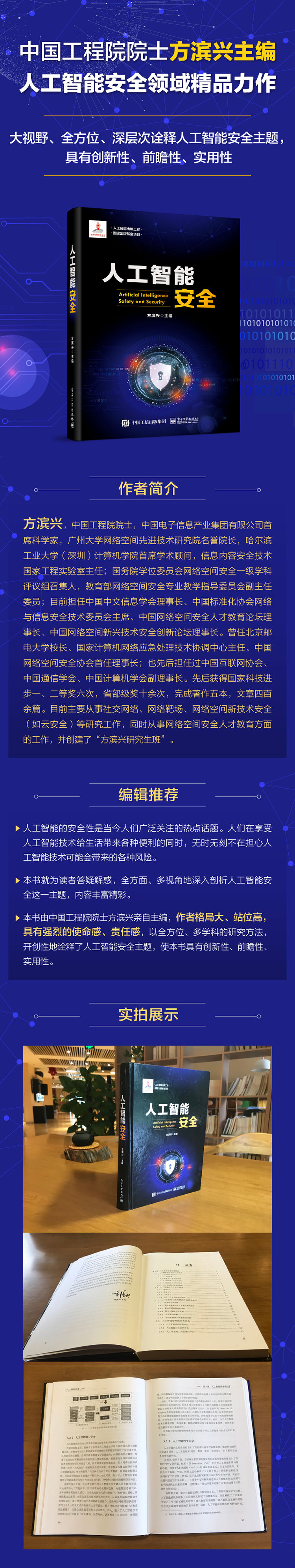

人工智能安全(精装版)

| 书籍作者:方滨兴 | ISBN:9787121389917 |

| 书籍语言:简体中文 | 连载状态:全集 |

| 电子书格式:pdf,txt,epub,mobi,azw3 | 下载次数:1377 |

| 创建日期:2021-02-14 | 发布日期:2021-02-14 |

| 运行环境:PC/Windows/Linux/Mac/IOS/iPhone/iPad/Kindle/Android/安卓/平板 | |

内容简介

本书在简要介绍人工智能发展历程、世界各国人工智能战略规划之后,重点围绕人工智能安全主题,提出人工智能安全体系架构,讨论了人工智能助力安全、人工智能内生安全、人工智能衍生安全等相关内容,并深入研究了人工智能安全伦理准则。本书还详细分析了人工智能行为体及其可能引发的安全问题,提出了人工智能保险箍的解决方案,并给出了人工智能行为体的安全评估与检测方法。本书最后还探讨了人工智能的前沿技术,以及人工智能安全的未来发展趋势。

本书适合人工智能及安全领域的研究人员、管理人员以及广大爱好者阅读。

作者简介

方滨兴,中国工程院院士,中国电子信息产业集团有限公司首席科学家,广州大学网络空间先进技术研究院名誉院长,哈尔滨工业大学(深圳)计算机学院首席学术顾问,信息内容安全技术国家工程实验室主任;国务院学位委员会网络空间安全一级学科评议组召集人,教育部网络空间安全专业教学指导委员会副主任委员;目前担任中国中文信息学会理事长、中国标准化协会网络与信息安全技术委员会主席、中国网络空间安全人才教育论坛理事长、中国网络空间新兴技术安全创新论坛理事长。曾任北京邮电大学校长、国家计算机网络应急处理技术协调中心主任、中国网络空间安全协会首任理事长;也先后担任过中国互联网协会、中国通信学会、中国计算机学会副理事长。先后获得国家科技进步一、二等奖六次,省部级奖十余次,完成著作五本,文章四百余篇。目前主要从事社交网络、网络靶场、网络空间新技术安全(如云安全)等研究工作,同时从事网络空间安全人才教育方面的工作,并创建了“方滨兴研究生班”。

编辑推荐

人工智能的安全性是当今人们广泛关注的热点话题。人们在享受人工智能技术给生活带来各种便利的同时,无时无刻不在担心人工智能技术可能会带来的各种风险。

本书就为读者答疑解惑,全方面、多视角地深入剖析人工智能安全这一主题,内容丰富精彩。

本书由中国工程院院士方滨兴亲自主编,作者格局大、站位高,具有强烈的使命感、责任感,以全方位、多学科的研究方法,开创性地诠释了人工智能安全主题,使本书具有创新性、前瞻性、实用性。

前言

前 言

无论何时,只要人们谈及网络空间安全的形势,一定会有“形势严峻”、“应对能力不足”等悲观的说法,这往往会让决策者感到迷惑:网络空间安全领域为何总是缺少作为呢?到底该如何做才能让网络空间安全问题不再时刻困扰人们呢?其实这一切都是由于网络空间安全的动态属性所决定的。习近平总书记在2016年4月19日网络安全和信息化工作座谈会上指出:要树立正确的网络安全观,网络安全是动态的而不是静态的。也就是说,网络空间安全的形态是不断变化的,一个安全问题解决了,另一个安全问题又会冒出来。而在网络空间安全的动态属性中,新技术安全是导致网络空间安全具有动态特征的主要因素之一,这是因为新技术必然会带来新的安全问题,而各种新技术、新系统源源不断地出现,自然会引发各种新的安全问题与安全事件。如果我们有能力让各种新技术都停止出现,五年内信息技术不更新,那么当前所有的信息安全问题可能将被全部解决掉,将会有一个十分安全的网络空间展现在人们的眼前。然而,社会不可能停滞不前,新技术也不可能从此就销声匿迹,网络空间安全将伴随着新技术的出现持续动态地变化。

新技术必然会带来新的安全问题,这是新技术在安全方面的伴生效应。这种伴生效应会产生两方面的安全问题:一是由于新技术的出现,其自身的脆弱性会导致新技术系统出现不稳定或者不安全的情况,这方面的问题是新技术的内生安全问题;另一方面是新技术自身缺陷可能并不影响新技术系统自身的运行,但这种缺陷却给其他领域带来了问题,导致其他领域变得不安全,这方面的问题是新技术的衍生安全问题。

除了伴生效应以外,新技术的出现一定会提升相关领域的势能,当新技术运用于安全领域的时候,自然也会赋能安全领域,这可称为新技术的赋能效应。当然,新技术在安全领域的赋能,既可以赋能于防御,也可能赋能于攻击,即新技术被恶意利用而导致其他领域不安全。显然,新技术赋能攻击是导致网络空间安全形势始终不够乐观的推手之一。

人工智能技术尽管产生于20世纪50年代,但其几起几落,形成了螺旋式的发展轨迹。人工智能技术在21世纪里因为其在应用领域中取得了突出的成就,从而被认定是信息领域中的一种推动社会发展的新技术。事实上,推动人工智能快速发展、使之在应用领域中切实发挥作用的那些具体技术也的确是21世纪所出现的新技术,例如深度学习、软件框架等。因此,将人工智能技术看作是信息领域的新技术并不为过。人工智能技术被认定为新技术的另一原因表现在世界各国政府对人工智能技术的高度重视,以及在人工智能技术领域所给予的巨额投资,展示出国际社会对人工智能技术造福人类所给予的极大期望。

但是,作为新技术,人工智能技术自然也会存在着安全问题的伴生效应与安全领域的赋能效应。从伴生效应的视角来看,人工智能存在着内生安全问题。例如,人工智能算法大量依赖统计结果,尤其是神经网络等智能学习系统,这种系统通过调整隐藏层内部的连接权值来记录系统通过统计学习后获得的特征信息。但这些权值意味着什么几乎是无法解释的,所以人们对之只能使用,无法预判。在这种情况下,系统对哪些权值进行了怎样的修改、修改后会导致系统的判断结果会怎样跳出人们的预期都是不可知的,而且什么样的学习过程会导致这种修改也是不可知的,这就为目前普遍流行的被称为“对抗样本攻击”的人工智能攻击手段敞开了大门。由此,“对抗样本攻击”可以被归为人工智能技术伴生的内生安全问题。同样的情况,人工智能系统的不可解释性也许不会影响人工智能系统在一般情况下的运行状态,但是否会导致人工智能系统可能出现失控的情况,造成系统可能会不按照人类所预计的或所期望的方式运行?而这种不可预计的情况是否会给人类带来威胁?这些问题都令人细思极恐。如果一个助残机器人不按照人类期望的方式运动,其结果反倒会伤害人类,这时人们反而会发现助残机器人的智能越低其失控的概率也许越小。所以这类可能出现的“失控”问题是人工智能技术伴生的衍生安全问题。

就人工智能技术在安全领域中的赋能效应而言,我们可以举出许多利用人工智能技术进行安全防御或者进行安全攻击的例子。将人工智能技术运用到网络安全态势感知是典型的赋能防御的案例;而利用人工智能技术来攻击人脸识别系统——用Deepfake技术来进行实时换脸以绕过人脸识别过程中的新鲜度检测——的手法则是典型的赋能攻击的案例。

正是因为人工智能技术受到了各国政府的重视,国际社会也期望通过人工智能技术来显著地改善人们的生产与生活方式,甚至包括国家的治理模式,这使得人工智能技术领域的研究视角大都集中在如何发展人工智能技术、如何推进人工智能技术的市场化应用上来,而这种高速推动人工智能技术发展的力量会进一步强化人工智能技术的发展与人工智能安全被忽视之间的不均衡态势。人们沉浸在人工智能技术所带来的社会变化的喜悦中,很容易忽视人工智能技术安全问题的伴生效应,以及人工智能技术在安全领域中的赋能攻击效应。作为专业从事网络空间安全技术研究的团队,我们认为是时候要让人们对人工智能安全问题警醒了。事实上,人工智能技术所伴生的已经不仅仅是内生安全问题和衍生安全问题,还涉及到伦理、法律等一系列与社会治理有关的挑战性问题。为此,以广州大学网络空间先进技术研究院的团队为主,本人组织了一批学者编撰了本书,旨在让人们在高度关注人工智能技术发展的同时,也注意到人工智能安全问题及相应技术的演进。

本书共12章。其中,第1章人工智能技术发展概述由方滨兴、韩伟红主笔,第2章各国人工智能发展战略规划由李树栋、方滨兴主笔,第3章人工智能安全概述由崔翔主笔,第4章人工智能助力安全由廖鹏主笔,第5章人工智能的内生安全由顾钊铨主笔,第6章人工智能衍生安全问题由苏申、田志宏主笔,第7章人工智能行为体由鲁辉主笔,第8章人工智能行为体保险箍由田志宏、崔翔主笔,第9章人工智能行为体的安全评估与检测由方滨兴、蒋琳主笔,第10章人工智能安全伦理准则由方滨兴、尹捷主笔,第11章人工智能前沿技术由李默涵主笔,第12章人工智能安全的未来展望由方滨兴、顾钊铨主笔。全书由方滨兴、顾钊铨、崔翔通稿。本书在撰写过程中得到了高文院士的指导,在此表示诚挚的谢意。此外,还要感谢电子工业出版社的赵丽松和沈艳波两位副总编,她们为本书的出版做了大量辛勤工作。

人工智能技术的发展历史很长,先后出现了不同的研究方法与技术路线,尽管大部分的研究结果可以说是殊途同归,但学者们仍然存在着各执己见、自成体系的情况。在这种情况下,本书难以涵盖所有学术流派的研究路线,也就无法针对各种情况来论述相应的安全问题。本书只求抛砖引玉,仅就所关注到的人工智能技术论述其所关联到的安全问题及相关技术,疏漏之处,还望读者理解。

目录

第1章人工智能技术发展概述

1.1人工智能的研究方向及起源

1.1.1人工智能的研究方向

1.1.2人工智能起源

1.2人工智能的三次发展高峰

1.2.1人工智能第一次发展高峰

1.2.2人工智能第二次发展高峰

1.2.3人工智能第三次发展高峰

1.3人工智能的三个学术流派

1.3.1符号主义

1.3.2连接主义

1.3.3行为主义

1.3.4关于三个学术流派的评论

1.4人工智能第三次发展高峰的技术推手

1.4.1深度学习的贡献

1.4.2软件框架成为人工智能应用的推手

1.4.3解决不同软硬件的适配

1.4.4算力大幅提升的贡献

1.4.5大数据的贡献

1.4.6移动互联网与传感器的贡献

1.5人工智能带来的巨大冲击

1.5.1人工智能对经济的冲击

1.5.2人工智能对社会的冲击

1.5.3人工智能对人类思维的冲击

1.5.4人工智能对教育与就业的影响

1.5.5人工智能对隐私的冲击

1.6本章小结

参考文献

第2章世界各国人工智能发展战略规划

2.1美国人工智能发展战略

2.1.1美国人工智能发展职能机构

2.1.2美国人工智能战略规划

2.1.3美国人工智能发展计划

2.1.4美国人工智能监管政策

2.2欧盟及英国人工智能发展战略

2.2.1欧盟及英国的人工智能战略

2.2.2欧盟人工智能发展计划

2.2.3欧盟及英国的人工智能伦理原则

2.2.4欧盟及英国人工智能立法及监管

2.3其他一些国家人工智能发展战略

2.3.1日本人工智能发展战略

2.3.2俄罗斯人工智能发展战略

2.3.3韩国、新加坡、加拿大、印度等国的人工智能战略

2.4中国人工智能发展战略

2.4.1中国人工智能发展的总体要求

2.4.2中国人工智能发展的主要任务

2.4.3中国人工智能产业发展的资源配置

2.4.4中国人工智能发展的保障措施

2.4.5中国人工智能发展的组织保障

2.4.6中国人工智能人才培养政策

2.5国内外人工智能标准研究

2.5.1国际人工智能标准研究

2.5.2中国人工智能标准研究

2.6本章小结

参考文献

第3章人工智能安全概述

3.1人工智能与安全的辩证关系

3.2人工智能安全体系架构与分类

3.2.1人工智能安全体系架构

3.2.2人工智能助力安全

3.2.3人工智能内生安全

3.2.4人工智能衍生安全

3.3人工智能安全所处位置及外部关联

3.3.1人工智能安全性、可靠性和可控性的关系

3.3.2人工智能安全与法律、政策和标准的关系

3.3.3人工智能安全与伦理之间的关系

3.3.4人工智能安全评测与防控

3.4本章小结

参考文献

第4章人工智能助力安全

4.1人工智能助力安全概述

4.2人工智能助力防御

4.2.1物理智能安防监控

4.2.2军用机器人

4.2.3智能入侵检测

4.2.4恶意代码检测与分类

4.2.5基于知识图谱的威胁猎杀

4.2.6用户实体行为分析

4.2.7垃圾邮件检测

4.3人工智能助力攻击

4.3.1自动化网络攻击

4.3.2助力网络攻击,提升网络攻击效率

4.3.3助力有害信息的传播

4.3.4助力虚假信息内容的制作

4.3.5智能恶意代码

4.3.6神经网络后门

4.3.7对抗机器学习

4.3.8智能工具被用于恶意攻击

4.3.9助力自主武器研发

4.4本章小结

参考文献

第5章人工智能的内生安全

5.1数据安全

5.1.1数据集质量影响人工智能内生安全

5.1.2数据投毒可人为导致人工智能算法出错

5.1.3对抗样本成为人工智能内生安全的新关注点

5.2框架安全

5.3算法安全

5.3.1算法的可解释性

5.3.2对抗样本体现出人工智能算法缺乏可解释性

5.4模型安全

5.4.1模型存储和管理的安全

5.4.2开源模型被攻击

5.5运行安全

5.5.1客观原因导致的运行安全问题

5.5.2主观原因导致的运行安全问题

5.6本章小结

参考文献

第6章人工智能衍生安全问题

6.1人工智能系统失误而引发的安全事故

6.1.1自动驾驶汽车失效

6.1.2智能机器人失效

6.1.3智能音箱失效

6.1.4人工智能系统“失控”

6.1.5会话人工智能的偏激言论

6.1.6医疗人工智能的危险治疗意见

6.2人工智能武器研发可能引发国际军备竞赛

6.2.1各国人工智能武器化发展情况

6.2.2人工智能武器军备竞赛带来的风险

6.3人们对人工智能技术失控的担忧

6.4人工智能行为体失控三要素

6.4.1人工智能行为体具有行为能力以及破坏力

6.4.2人工智能行为体具有不可解释的决策能力

6.4.3人工智能行为体具有进化能力,可进化成自主系统

6.5预防人工智能技术失控的举措

6.5.1人机协作国际规范

6.5.2阿西洛马人工智能原则

6.5.3自我终结机制防范系统性失控风险

6.6本章小结

参考文献

第7章人工智能行为体

7.1人工智能行为体的定义

7.2人工智能行为体类型1——传统型

7.2.1工业机器人

7.2.2专用服务机器人

7.2.3家用型机器人

7.3人工智能行为体类型2——自动驾驶的交通工具

7.3.1自动驾驶简介

7.3.2自动驾驶汽车

7.3.3人工智能无人机

7.3.4无人驾驶船舶

7.4人工智能行为体类型3——人工智能武器

7.4.1人工智能武器简介

7.4.2“杀人蜂” 武器

7.4.3炮塔型AI战斗机器人

7.4.4人形战斗机器人

7.5人工智能行为体类型4——类人机器人

7.5.1Jules机器人

7.5.2Bina48机器人

7.5.3Sophia机器人

7.6人工智能行为体的特性

7.6.1人工智能行为体的移动特性

7.6.2人工智能行为体的决策特性

7.6.3人工智能行为体的自主特性

7.7本章小结

参考文献

第8章人工智能行为体保险箍

8.1体系架构

8.2基本功能

8.2.1远程控制组件

8.2.2能源控制组件

8.2.3宿主交互组件

8.2.4数据记录组件

8.3安全机制

8.3.1设备安全

8.3.2数据安全

8.3.3运行安全

8.4安全围栏

8.4.1工作过程

8.4.2移动范围限制

8.4.3速度与距离监控

8.4.4输出功率与力约束

8.4.5安全策略

8.5增强功能

8.5.1内置传感器

8.5.2人的识别

8.5.3“黑AIA”识别

8.6防控中心

8.6.1态势感知

8.6.2指挥控制

8.6.3应急处置

8.6.4专家研判

8.7生态环境

8.7.1准入制度

8.7.2标准规范

8.7.3生态基础

8.8本章小结

参考文献

第9章人工智能行为体的安全评估与检测

9.1人工智能行为体的安全管理概述

9.1.1从术语的角度感受个人助理机器人的安全要素

9.1.2个人助理机器人的风险评估要求

9.1.3个人助理机器人的安全要求

9.1.4个人助理机器人的功能安全

9.2人工智能行为体安全评估和检测的目标

9.2.1动能安全:对AIA动能的评估

9.2.2决策安全:对决策系统安全的评估

9.2.3自主安全:对AIA自主能力失控风险的评估

9.3人工智能行为体安全评估的方法与指标

9.3.1动能安全评估

9.3.2决策安全评估

9.3.3自主安全评估

9.3.4安全评估过程

9.4人工智能行为体检测能力与检测方法

9.4.1针对AIA动能的检测方法

9.4.2针对AIA决策机制的检测方法

9.4.3针对AIA自主能力的检测方法

9.5人工智能行为体的检测流程

9.5.1针对AIA动能的检测流程

9.5.2针对AIA决策机制的检测流程

9.5.3针对AIA自主能力的检测流程

9.6本章小结

参考文献

第10章人工智能安全伦理准则

10.1人工智能技术引发的伦理问题

10.1.1人权问题

10.1.2伦理地位问题

10.1.3责任伦理问题

10.1.4风险问题

10.2人工智能技术发展的伦理准则

10.2.1各国政府及社团组织关于人工智能技术发展的伦理准则

10.2.2国际组织关于人工智能技术发展的伦理准则

10.2.3企业和高等院校关于人工智能技术发展的伦理准则

10.3人工智能行为体的伦理决策

10.3.1人工智能行为体的伦理决策能力

10.3.2人工智能行为体的伦理决策设计

10.3.3人工智能行为体的伦理决策考量

10.4人工智能行为体的责任归咎

10.4.1责任主体

10.4.2责任分配

10.4.3无人驾驶汽车的责任追究

10.5本章小结

参考文献

第11章人工智能前沿技术

11.1学术前沿

11.1.1强化学习

11.1.2迁移学习

11.1.3联邦学习

11.1.4分布式机器学习

11.1.5表示学习

11.1.6元学习

11.1.7可解释的人工智能

11.1.8对抗训练

11.1.9人工智能芯片

11.1.10技术前沿安全挑战

11.2应用前沿

11.2.1计算机视觉

11.2.2自然语言处理

11.2.3智能语音

11.2.4智能驾驶

11.2.5拟人和仿生

11.2.6智能攻防

11.2.7应用前沿安全挑战

11.3交叉领域

11.3.1人工智能与互联网

11.3.2人工智能与工业互联网

11.3.3人工智能与医学生物

11.3.4人工智能与军事

11.3.5人工智能与商业模式

11.3.6人工智能与人文社会

11.3.7交叉领域安全挑战

11.4本章小结

参考文献

第12章人工智能安全的未来展望

12.1人工智能内生安全的未来展望

12.1.1数据是否会制约人工智能内生安全

12.1.2对抗样本是否会出现在实际应用场景中

12.1.3是否存在安全的智能模型

12.1.4人工智能执行过程是否安全

12.2人工智能衍生安全的未来展望

12.2.1人工智能武器化

12.2.2人工智能滥用导致安全隐患

12.2.3人工智能是否会危害人类

12.3人工智能安全相关的未来焦点

12.3.1人工智能基础工具应注重自主可控

12.3.2如何看待人工智能自主发明物的专利性问题

12.3.3人工智能对人的影响

12.3.4人工智能挑起的欲望

12.3.5超人工智能是否会危害人类

12.4人工智能的安全可控之路

12.4.1建立保护人类的法律规范和规章制度

12.4.2确立人类优先与安全优先的原则

12.4.3谨慎承认智能机器人的法律主体资格

12.4.4充分尊重社会公众的知情权

12.4.5人工智能的安全评估与检测

12.4.6人工智能安全可控需要社会各界共同的努力

12.5本章小结

参考文献

短评

没人传封面吗……

2020-07-06

产品特色